5 changed files with 52 additions and 5 deletions

BIN

image/20180111_000653.png

View File

BIN

image/20180111_000814.png

View File

BIN

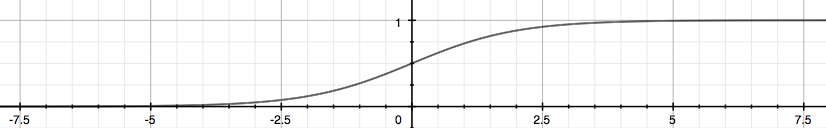

image/2413fbec8ff9fa1f19aaf78265b8a33b_Logistic_function.png

View File

+ 1

- 1

week3.html

File diff suppressed because it is too large

View File

+ 51

- 4

week3.md

View File

Loading…